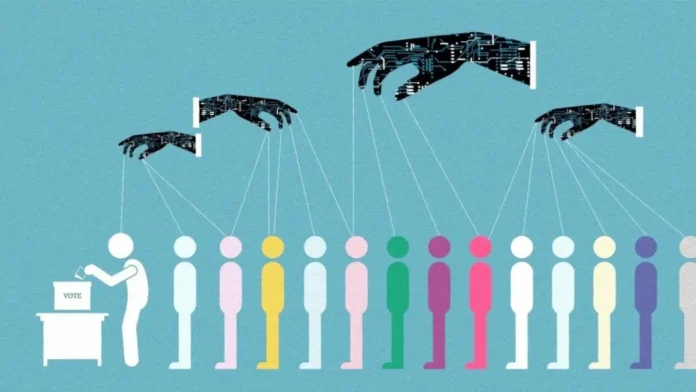

২০২৬ সালের জাতীয় নির্বাচন ঘনিয়ে আসার সঙ্গে সঙ্গে বাংলাদেশের রাজনৈতিক প্রচারে এক নতুন ও চিন্তাজনক প্রবণতা লক্ষ্য করা যাচ্ছে। সামাজিক যোগাযোগমাধ্যমে ছড়িয়ে পড়ছে অত্যন্ত বাস্তবধর্মী কৃত্রিম বুদ্ধিমত্তা বা এআই-চালিত ভিডিও।

গত জুন মাসের মাঝামাঝি সময় থেকে ফেসবুক ও টিকটকে এমন ডজনখানেক ভিডিও ভাইরাল হয়েছে যেখানে দেখা যাচ্ছে— বিভিন্ন শ্রেণি-পেশার মানুষ একটি নির্দিষ্ট রাজনৈতিক দলকে সমর্থন জানাচ্ছেন। ভিডিওগুলোতে যারা কথা বলছেন তারা কেউই বাস্তব মানুষ নন। এগুলো তৈরি করা হয়েছে গুগলের ভিডিও জেনারেশন টুল Veo 3 ব্যবহার করে, যেখানে মুখ, কণ্ঠস্বর এবং পরিবেশ সবই কৃত্রিমভাবে নির্মিত। অধিকাংশ ভিডিওতে কোথাও উল্লেখ নেই যে এটি এআই দ্বারা তৈরি।

এক ভিডিওতে একজন নারী বলছেন, তিনি ন্যায় ও উন্নয়নের স্বার্থে ভোট দেবেন একটি নির্দিষ্ট দলকে। আরেকটি ভিডিওতে এক বৃদ্ধ রিকশাচালক শপথ নিচ্ছেন ভোট দেবেন “ন্যায়বিচার ও সমতার” পক্ষে। কিন্তু বাস্তবে এই মানুষগুলোর কেউই অস্তিত্ব রাখেন না।

গবেষণা সংস্থা Dismislab জানিয়েছে, ১৮ থেকে ২৮ জুনের মধ্যে ফেসবুকে এ ধরনের অন্তত ৭০টি ভিডিও প্রকাশিত হয়েছে, যার অনেকগুলোতেই মিলিয়নের বেশি ভিউ হয়েছে।

বিশেষজ্ঞদের মতে, এই ভিডিওগুলো “সফটফেইক” নামে পরিচিত। মানব বুদ্ধিমত্তা প্রতিষ্ঠান Humane Intelligence-এর প্রধান ড. রুম্মান চৌধুরী বলেন, “সফটফেইক” ভিডিওগুলো সরাসরি মিথ্যা বা মানহানিকর না হলেও এগুলো বাস্তবের কাছাকাছি কিছু উপস্থাপন করে জনগণের মানসিকতা প্রভাবিত করে। আর এতেই বাড়ছে আশঙ্কা।

এআই-চালিত রাজনৈতিক প্রচারের এই প্রবণতা ভারত ও পাকিস্তানেও দেখা গেছে। বাংলাদেশে এখনো স্পষ্ট নীতিমালা না থাকায় এখানেও তা ছড়িয়ে পড়ছে বলে মনে করছেন প্রযুক্তি বিশ্লেষকেরা।

যদিও মেটা ও টিকটক-এর মতো সামাজিক মাধ্যম প্ল্যাটফর্মগুলোতে এআই কনটেন্ট লেবেল করার নিয়ম রয়েছে, তবুও অধিকাংশ ভিডিওতে সে ধরনের কোনও লেবেল নেই বলে জানিয়েছে Dismislab।

বিশেষজ্ঞরা বলছেন, দেশের ডিজিটাল সাক্ষরতা ও সচেতনতার অভাব থাকায় সাধারণ মানুষ সহজেই এসব ভিডিওর প্রতারণায় পড়তে পারেন। এতে ভোটারদের মতামত প্রভাবিত হওয়ার আশঙ্কা বেড়ে যাচ্ছে।

নির্বাচন যতই এগিয়ে আসছে, ততই নীতিনির্ধারক ও নিয়ন্ত্রক সংস্থাগুলোর প্রতি জোরালো আহ্বান জানানো হচ্ছে— যেন দ্রুত কার্যকর নীতিমালা তৈরি ও বাস্তবায়ন করা হয়। না হলে, প্রযুক্তির এই অপব্যবহার ভবিষ্যতে নির্বাচন ও গণতন্ত্রের জন্য বড় হুমকি হয়ে উঠতে পারে।